前回のチュートリアル編ではEdge Impulse の後追いをやりつつ、Appendix で参考ページを見ていましたが、今回はそれらをまとめて、通しで実践してみました。

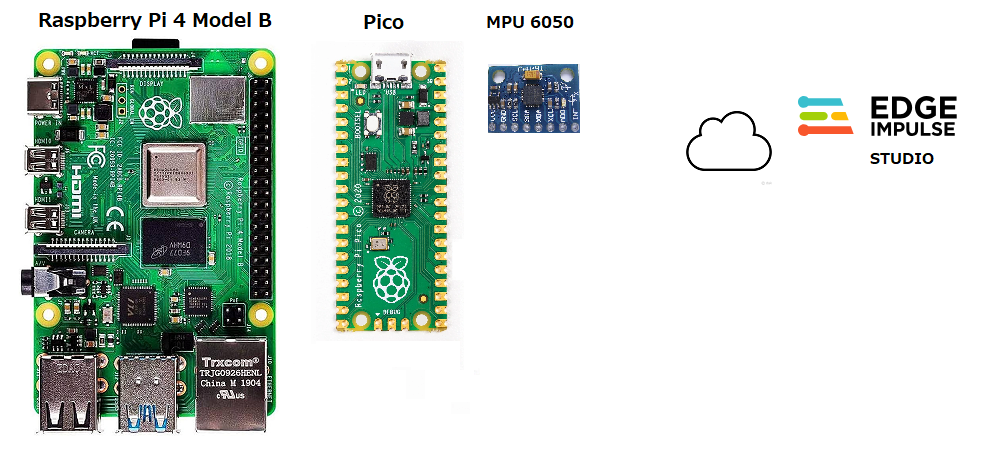

全体の構成

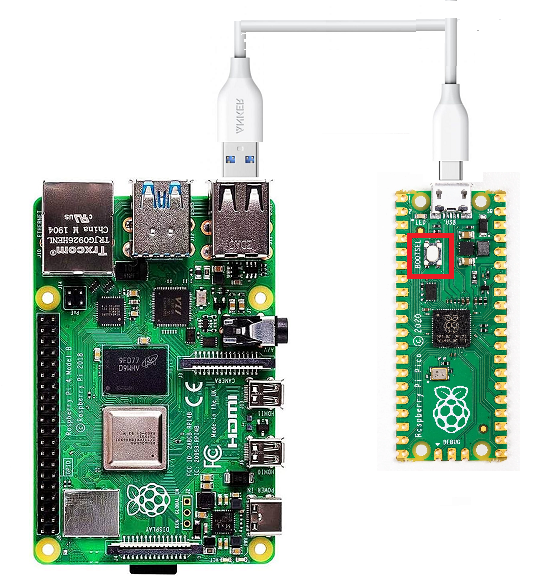

Raspberry Pi 4 Model B を母艦として、Pico がセンサー(MPU 6050)から得たデータやTinyML モデルの推論結果の表示に使います。

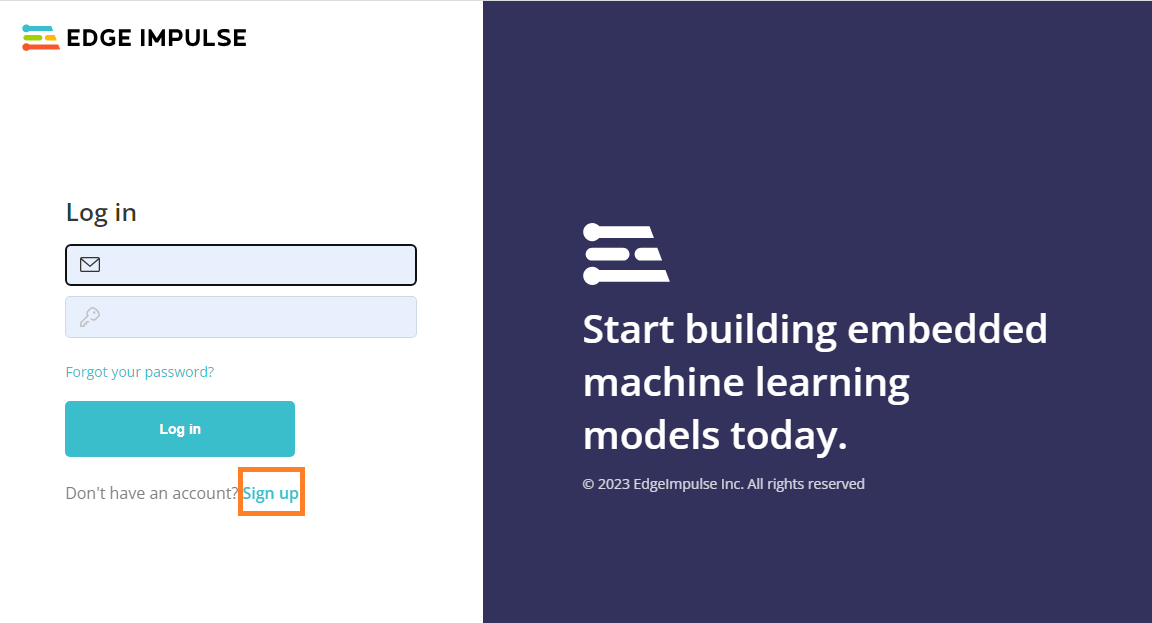

Edge Impulse にアカウントを作成しておきます。

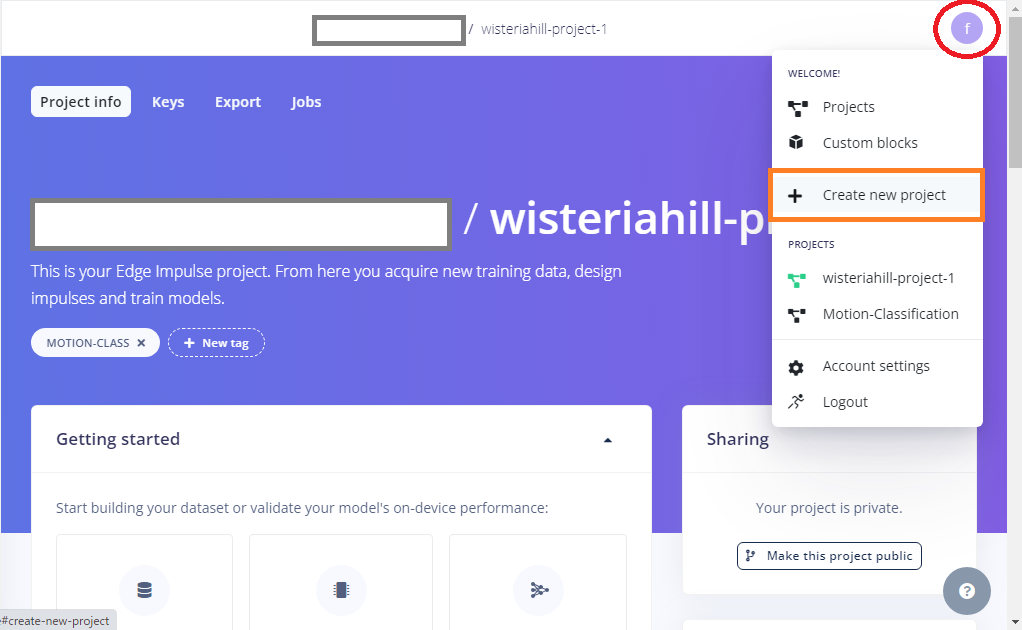

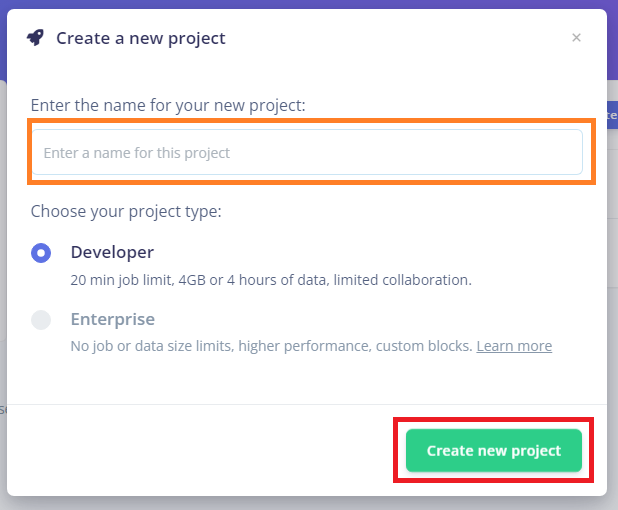

アカウントを作成したら、新しくプロジェクトも作成しておきます。

適当なプロジェクト名を入力して作成

Raspberry Pi 4 Model B に環境設定

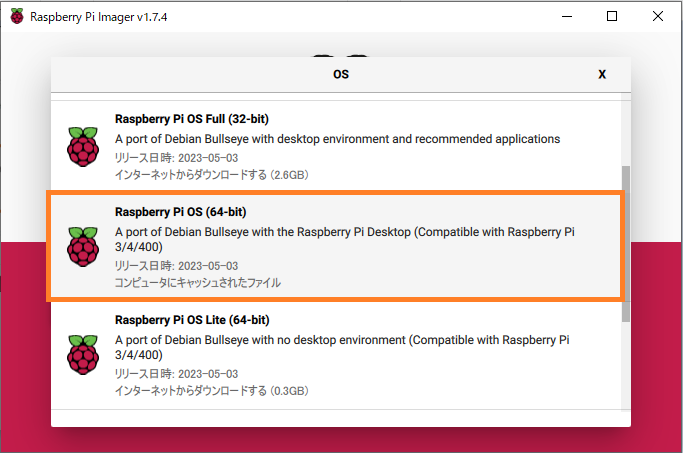

OSイメージは、Raspberry Pi OS (64-bit)Desktop にします。

ここにPico のファームウェア作成(C/C++)用にPico SDK をインストールしておきます。

|

1 2 3 4 5 6 7 8 9 10 11 |

sudo apt update sudo apt install git cmake gcc-arm-none-eabi libnewlib-arm-none-eabi build-essential -y cd ~/ mkdir pico cd pico git clone -b master https://github.com/raspberrypi/pico-sdk.git cd pico-sdk git submodule update --init cd .. |

次に、ラズパイ4にArduino IDE をインストールしておきます。

Arduino IDE はメインの開発環境ではありません。センサーのデータをシリアルポートに流すプログラムを作るためだけに使います。他に手段があればそっちを使っても可。

また、Arduino IDE にPico のボード情報をインストールしておきます。

Arduino IDE でPi Pico Wの開発用にEarle Philhower版を使う

シリアルポートのデータをモニタするためにminicomもインストールしておきましょう。

|

1 |

sudo apt install minicom -y |

Raspberry Pi 4 Model B , Raspberry Pi Pico とMPU 6050 でデータ収集の準備

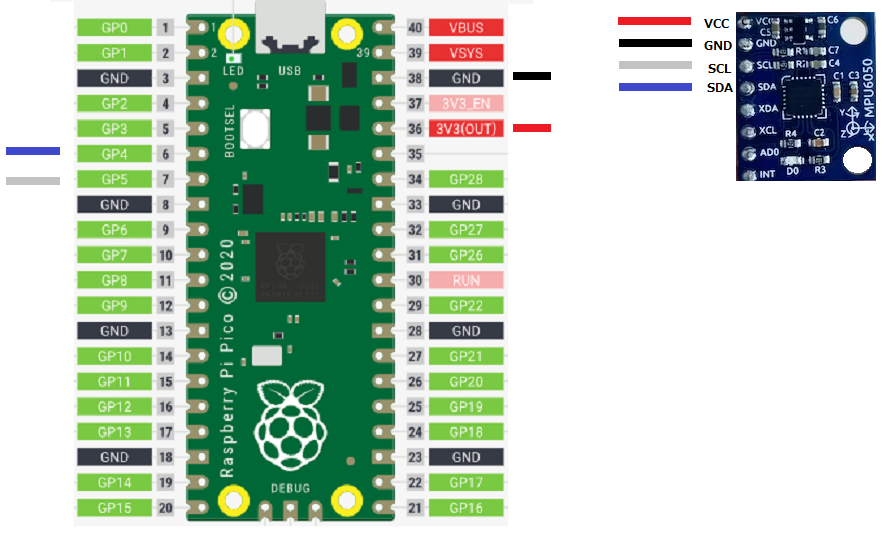

Pico とラズパイの結線

SDA -> GP4

SDL -> GP5

Pico のモーションデータをシリアル経由で取得します

Aduino IDE に以下のコードを記述(Gyaroのデータはコメントアウト)して実行。

実行時にどこに保存するか聞いてくるので、適当にフォルダーを作って保存しておきます。

(例:~/Arduino/MPU6050-PICO)

ここではdelay()を入れて、送信を50Hz前後に調整しています。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 |

#include <Wire.h> // MPU-6050のアドレス、レジスタ設定値 #define MPU6050_WHO_AM_I 0x80 #define MPU6050_PWR_MGMT_1 0x6B #define MPU_ADDRESS 0x68 // デバイス初期化 void setup() { Wire.begin(); // PCとの通信を開始 Serial.begin(115200); //115200bps // 初回の読み出し Wire.beginTransmission(MPU_ADDRESS); Wire.write(MPU6050_WHO_AM_I); //MPU6050_PWR_MGMT_1 Wire.write(0x00); Wire.endTransmission(); // 動作モードの読み出し Wire.beginTransmission(MPU_ADDRESS); Wire.write(MPU6050_PWR_MGMT_1); //MPU6050_PWR_MGMT_1レジスタの設定 Wire.write(0x00); Wire.endTransmission(); } void loop() { Wire.beginTransmission(0x68); Wire.write(0x3B); Wire.endTransmission(false); Wire.requestFrom(0x68, 14, true); while (Wire.available() < 14); int16_t axRaw, ayRaw, azRaw, gxRaw, gyRaw, gzRaw, Temperature; axRaw = Wire.read() << 8 | Wire.read(); ayRaw = Wire.read() << 8 | Wire.read(); azRaw = Wire.read() << 8 | Wire.read(); /* Temperature = Wire.read() << 8 | Wire.read(); gxRaw = Wire.read() << 8 | Wire.read(); gyRaw = Wire.read() << 8 | Wire.read(); gzRaw = Wire.read() << 8 | Wire.read(); */ // 加速度値を分解能で割って加速度(G)に変換 float acc_x = axRaw / 16384.0; //FS_SEL_0 16,384 LSB / g float acc_y = ayRaw / 16384.0; float acc_z = azRaw / 16384.0; /* // 角速度値を分解能で割って角速度(degrees per sec)に変換 float gyro_x = gxRaw / 131.0;//FS_SEL_0 131 LSB / (°/s) float gyro_y = gyRaw / 131.0; float gyro_z = gzRaw / 131.0; */ //Serial.println("Acc x,y,z"); Serial.print(acc_x); Serial.print(","); Serial.print(acc_y); Serial.print(","); Serial.print(acc_z); Serial.println(""); /* //Serial.println("Gyro x,y,z"); Serial.print(gyro_x); Serial.print(","); Serial.print(gyro_y); Serial.print(","); Serial.print(gyro_z); Serial.println(""); */ delay(15); } |

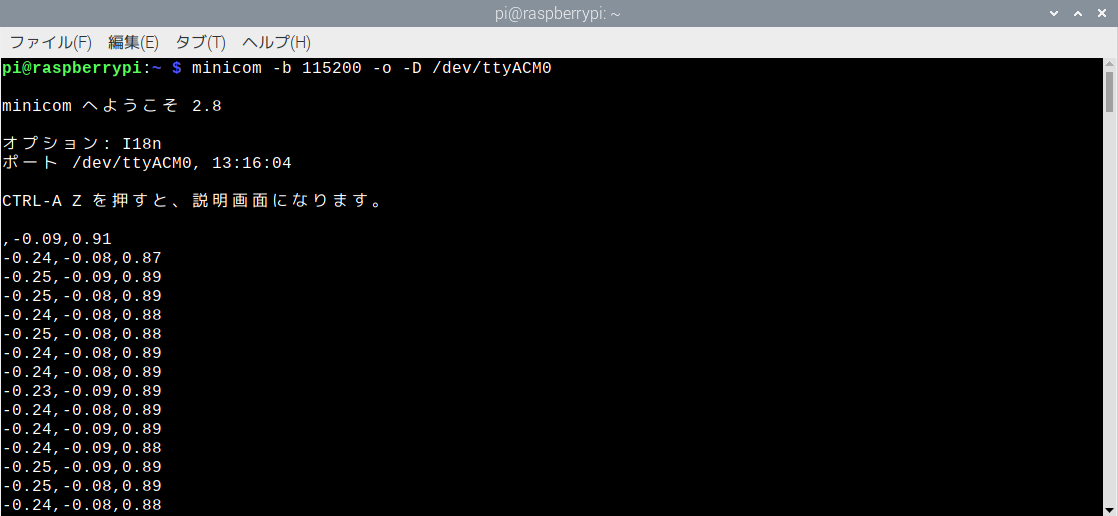

動作確認はminicomを使ってみましょう。

|

1 |

minicom -b 115200 -o -D /dev/ttyACM0 |

このままではIDE がしょっちゅう必要になるので、ファームウェアにしてPico にインストールしておきます。

IDEのメニュ -> スケッチ -> コンパイルしたバイナリを出力

uf2ファイルが上記でコードを保存したフォルダーに保存されます。

PicoのBOOTSELボタンを押しながらMicroUSBケーブルでラズパイに接続。

Pico がストレージとして認識されてフォルダーが開くので、作成したuf2ファイルをドラッグ・ドロップします。Pico は再起動してコードが実行され、シリアルポートにデータが流されます。

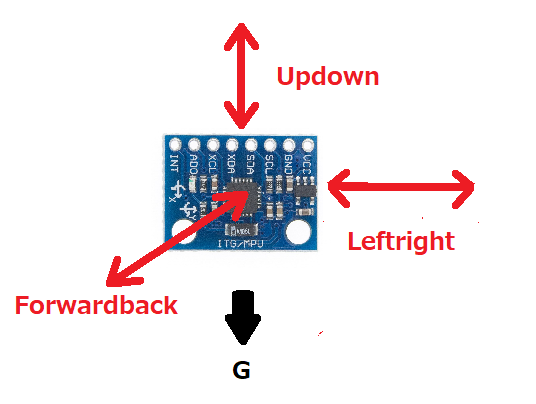

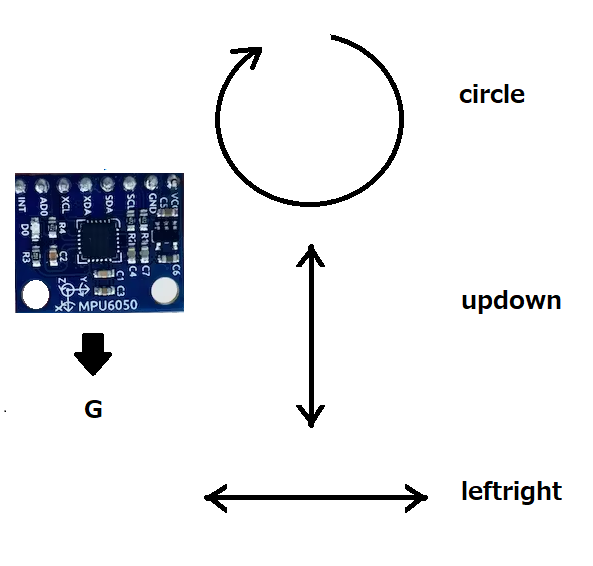

どういうモーションにするか決めておく

こういう3つの動作と何もしない状態(Idle)の4つのモーションにしてみます。

センサーは常に地面に対して垂直にしておきます。センサーのちょっとした傾き状態もモーションのデータとして保存されてしまいます。

相互に異なる正確なデータであるために余計な要素は極力排除します。

ただ、Updown やLeftright とCircleのようなモーション は明確には区別しずらいということはそれとなく分かります。

これら以外のモーションについては、ページ最後尾のAppendix に追記しています。

ローカルで採取されているモーションデータをクラウドのEdge Impulse Studio に転送準備

Edge Impulse CLI をラズパイにインストールします。

これはローカルのラズパイ-Pico とクラウドの Edge Impulse Studio を接続するために使います。

● Node.js v14 以上をインストール

最新のRaspberry Pi OS (64-bit)の場合、Node はVersion 15 以上が必要なようです。

|

1 2 3 |

curl -sL https://deb.nodesource.com/setup_15.x | sudo -E bash - sudo apt-get install -y nodejs node -v |

例えばバージョンが以下のように表示されます。

v15.14.0

|

1 |

npm config get prefix |

/usr

もし/usr/local/ が返された場合は、次のコマンドを実行して npm のデフォルト ディレクトリを変更します。

|

1 2 3 |

mkdir ~/.npm-global npm config set prefix '~/.npm-global' echo 'export PATH=~/.npm-global/bin:$PATH' >> ~/.profile |

● CLI toolsをインストール

|

1 |

npm install -g edge-impulse-cli |

データ転送にEdge Impulse Data forwarderを使用

Data forwarderは、シリアル経由で任意のデバイスから Edge Impulse にデータを簡単に中継するために使用されます。

デバイスはシリアル接続経由でセンサー値を書き込み、Data forwarderがデータを収集し、データに署名し、取り込みサービスにデータを送信します。

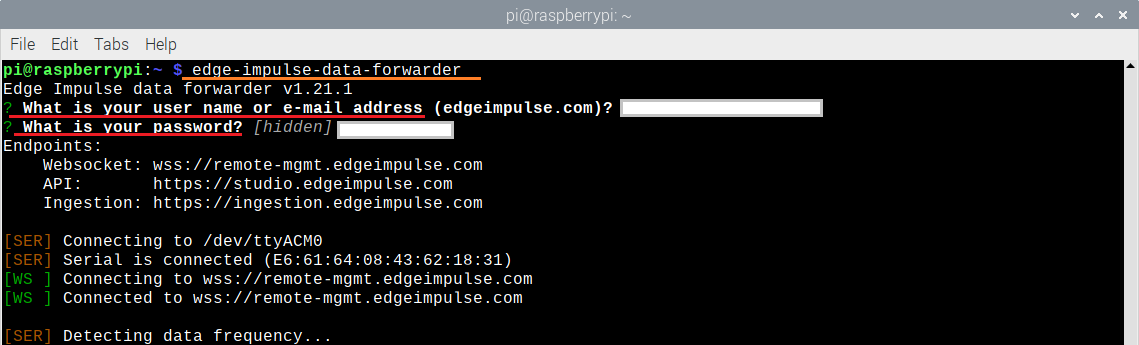

ターミナルで次を実行します。

minicom が実行中なら停止しておきます(Ctrl + A)。

|

1 |

edge-impulse-data-forwarder |

フルパス

~/.npm-global/bin/edge-impulse-data-forwarder

アカウント作成時のユーザー名(or メールアドレス)とパスワードを聞いてきます。パスワードは入力時何も反映されません。

どのプロジェクトを使うか聞いてきた場合は、矢印キーで指定します。

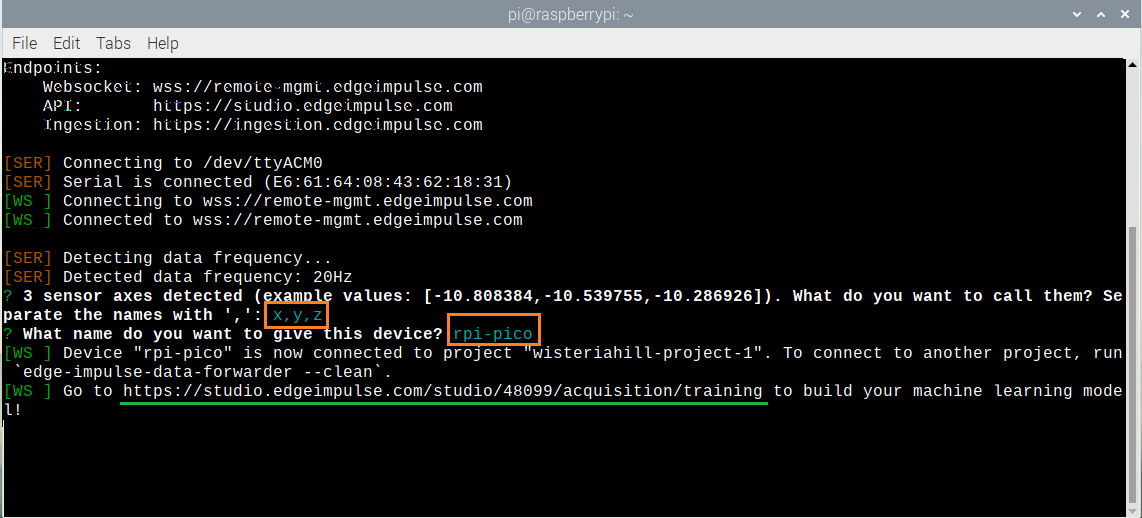

3つの軸を何と呼ぶのか聞いてきます。適当にカンマで区切って名前を入力(例:x,y,z)。またデバイス名を何とするのか聞いてきます。ここも適当に(例:rpi-pico)。

注:この軸に与える名称は需要なようです。後でEdge Impulse Studio でモデルを再利用したりデータを追加しようとする場合、再接続で軸の名称を間違えるとデバイスを認識してくれないようです。

うまくいくと、あなたが作ったプロジェクトに紐づけられます。

表示されたURLを控えておきます。

上記のURLにアクセスして、Edge Impulse Studio にログインします。

データを採取

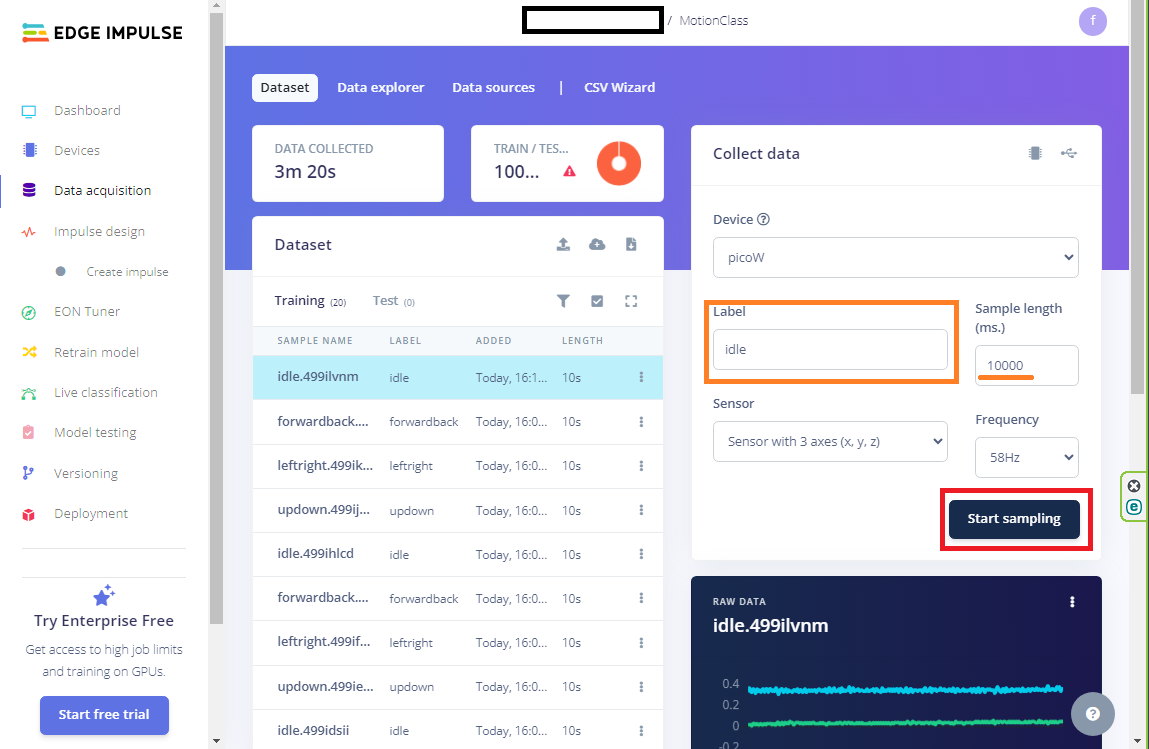

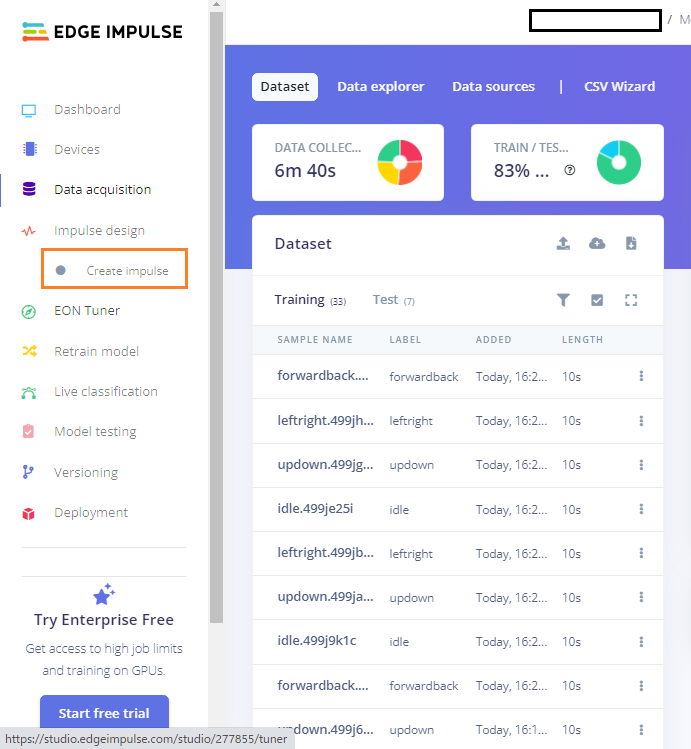

labelに上記の4つのモーション名(idle、updown、leftright、forwardback)を入れて、Start sampling をクリックし、それぞれのデータを採取します。

10秒(10000ms)間モーションを繰り返して採取します。目安は大体10回から15回くらい。

labelを入力ミスすると新しいモーションとみなされて追加されてしまいます。その場合は、選択して右端の3点アイコンをクリックし、Deleteで削除するか、Edit labelで修正します(Rename ではありません)。

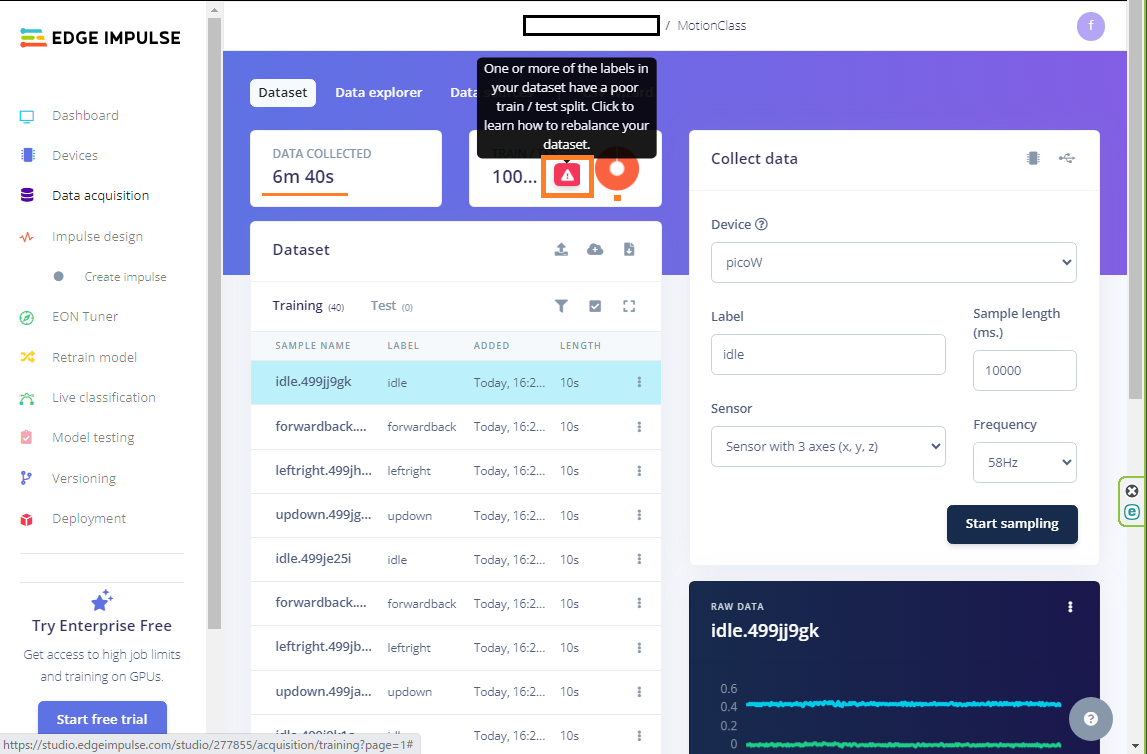

適当なところでデータを見てみます。赤い三角のアイコンをクリック。

こんな感じでよさげな量サンプリングされると、データを学習用とテスト用に分割するよう促してきます。

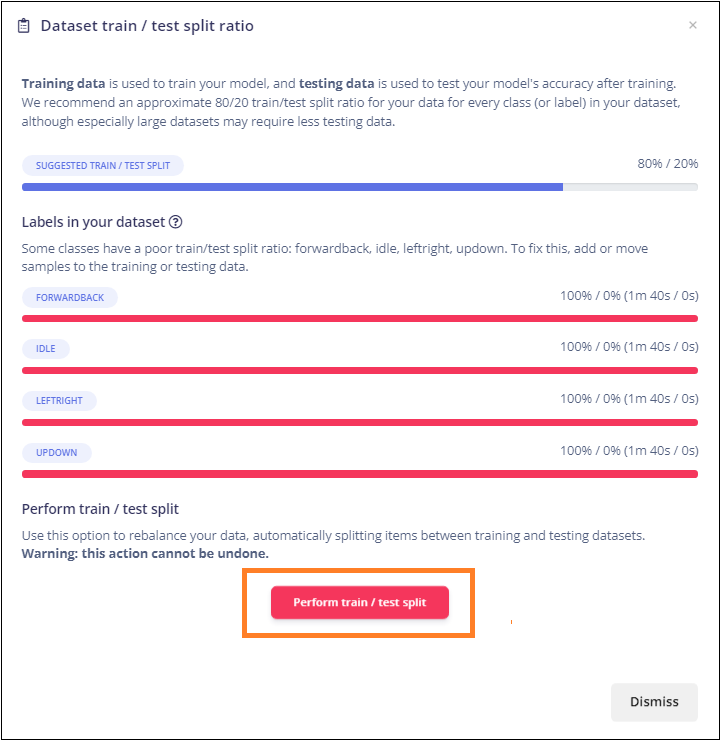

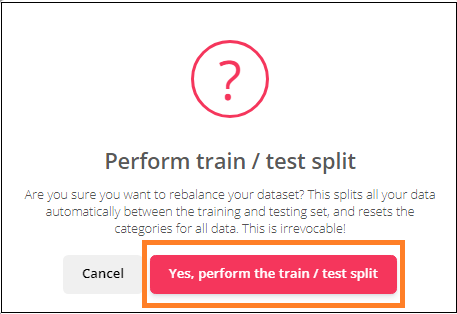

分割します。

確認してくるので「perform split」と入力して分割実行。

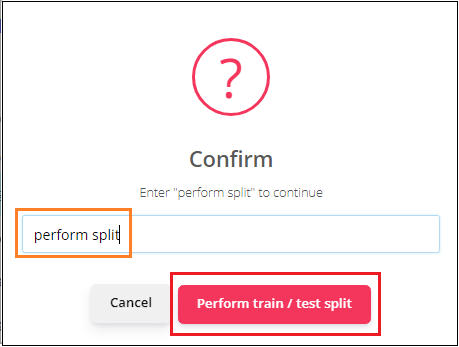

無事分割されるとグリーンの円グラフに変わっています。

分割を実行しても1部のデータが赤い線の表示のままで分割されないことがあります。そのモーションのみサンプリングを追加しながらsplitしてください。ほどよい量になったら分割されます。

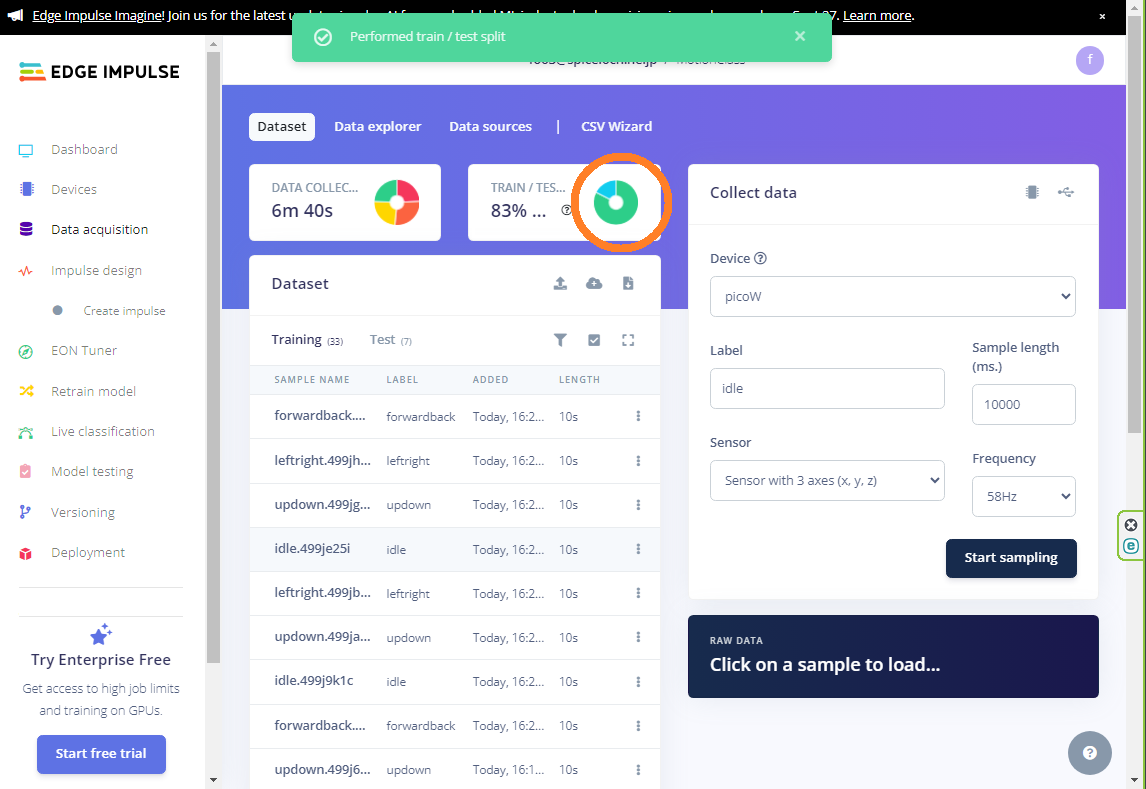

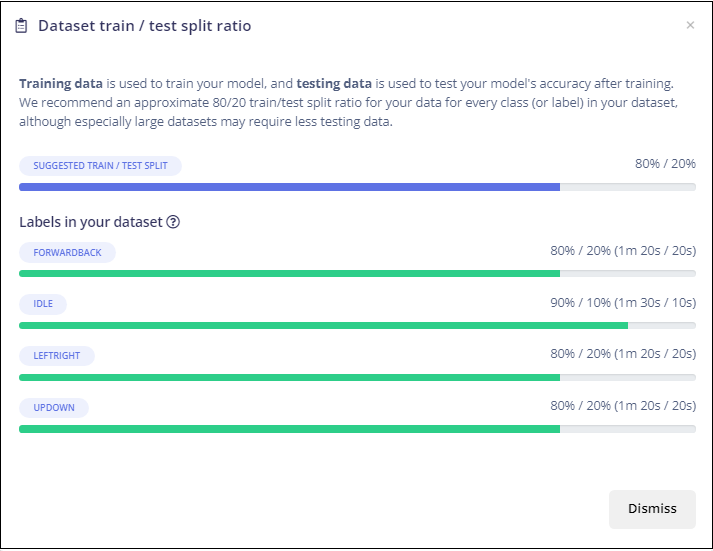

再度データ確認。こんな感じで、だいたい8:2くらいの割合で分割されています。

もう少しデータは採取したほうがいいのかもしれませんが、この辺りでデータの前処理とモデル作成に移行します。

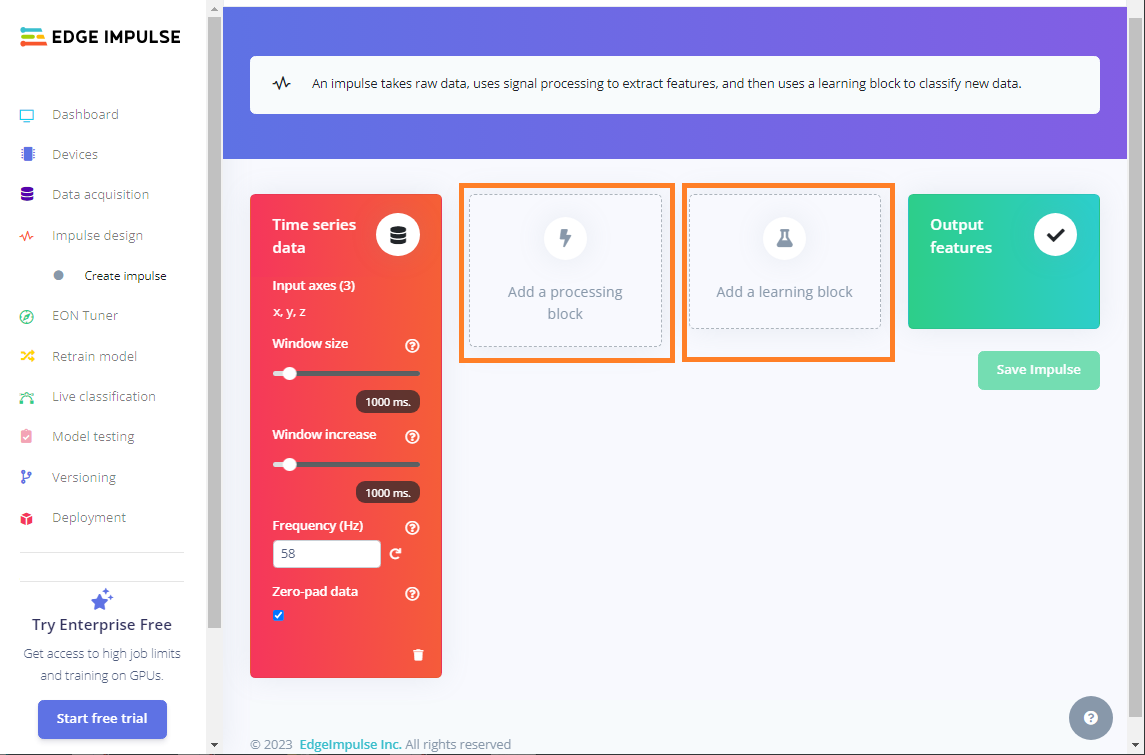

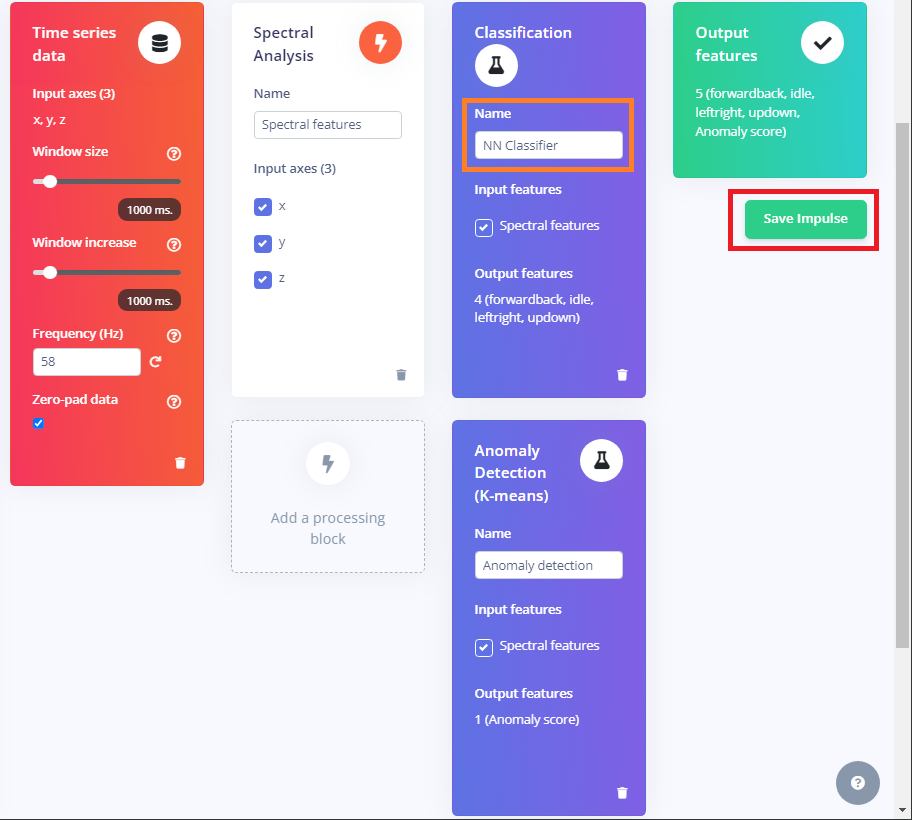

Create impulse でパイプラインを作成

メニュのCreate impulse をクリック。左のメインメニュが出ていない場合はページ左上のバーガーアイコンをクリックすれば出てきます。

こんな風に見やすいメニュでprocessing block とlearning block を追加するように聞いてきます。

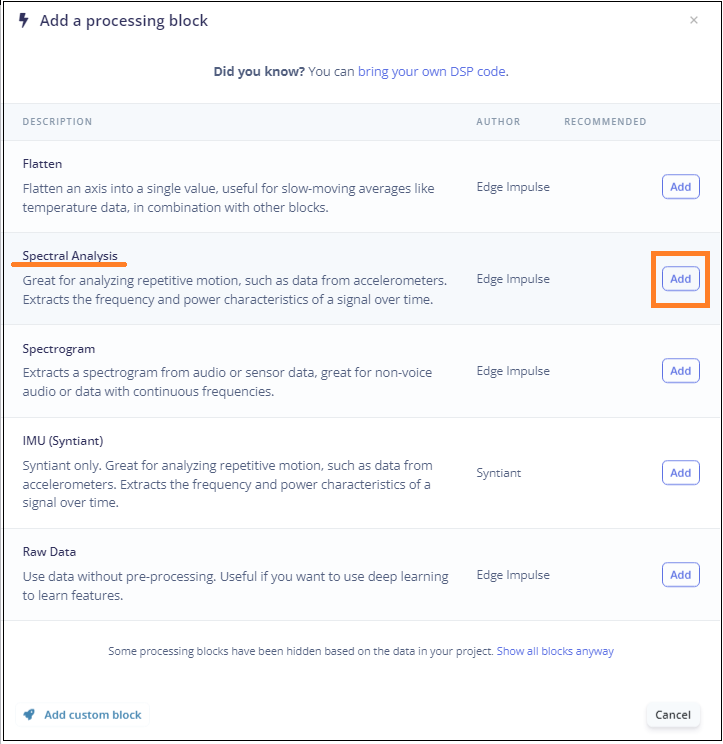

左の枠をクリックしてprocessing block 追加メニュを開きます。

なにも考えずにSpectral Analysisを追加。この環境ではFFTを使った変換をやっているようです…多分。

「加速度センサーからのデータなど、反復的な動きの分析に最適です。 時間の経過に伴う信号の周波数および電力特性を抽出します」……だそうです。

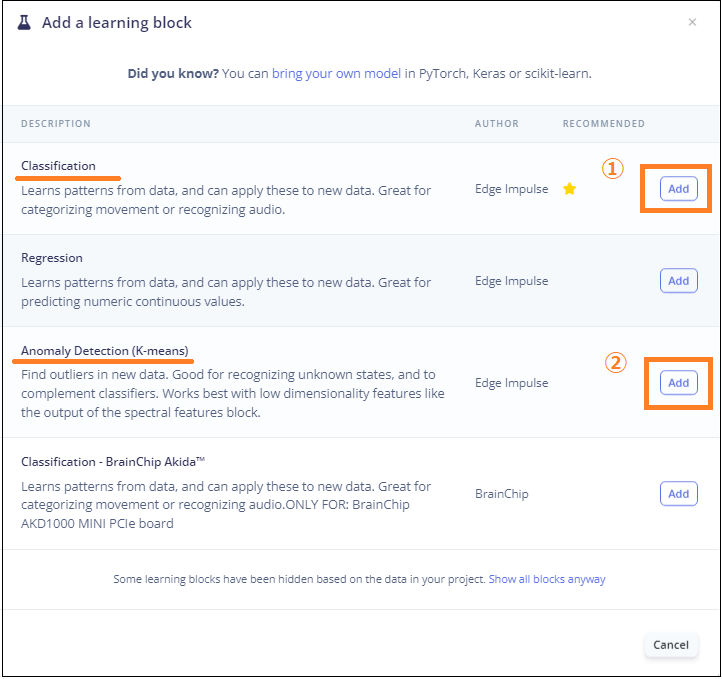

右のlearning block には2つ追加します。

なんでAnomaly Detection が必要なのか?

どうもデータの大きな外れ値を排除するのに使われるっぽい?実はよく分かっていません。ただ、これがあるとAccuracy は大幅に改善されます。

「新しいデータで外れ値を見つけます。 未知の状態を認識し、分類器を補完するのに適しています。 スペクトル特徴ブロックの出力などの低次元特徴で最もよく機能します」…….だそうです。

追加し終えたら、Classification のName は「NN Classifier」に変更して、Save impulseを実行。

名前の変更に深い意味はないと思います、どうも皆さんそうしているみたいなので……。

以上でパイプラインの作成は終了。

トレーニング

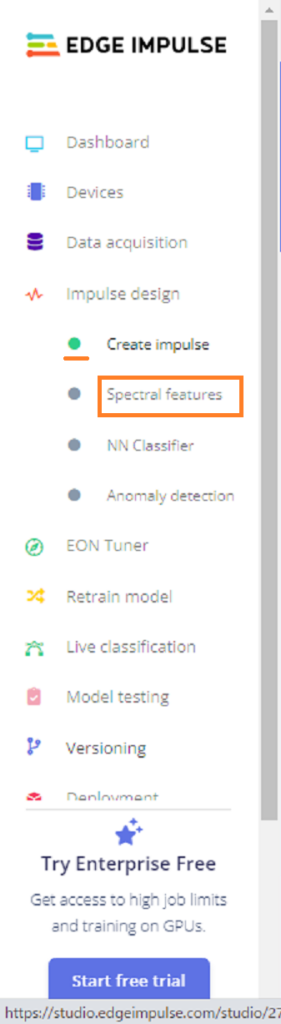

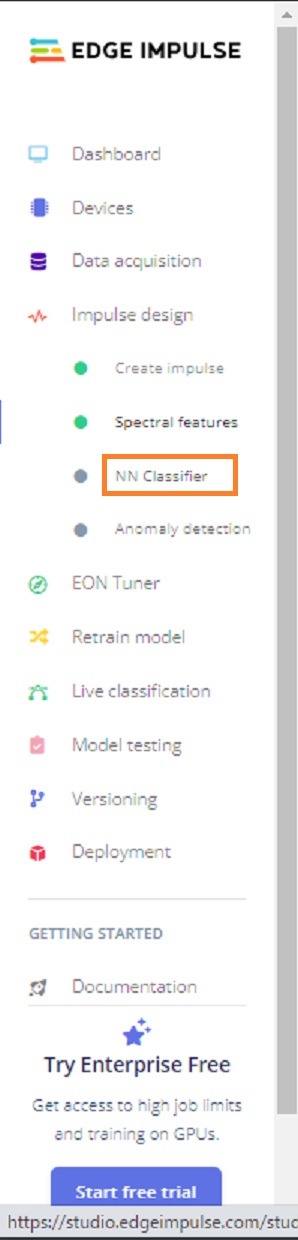

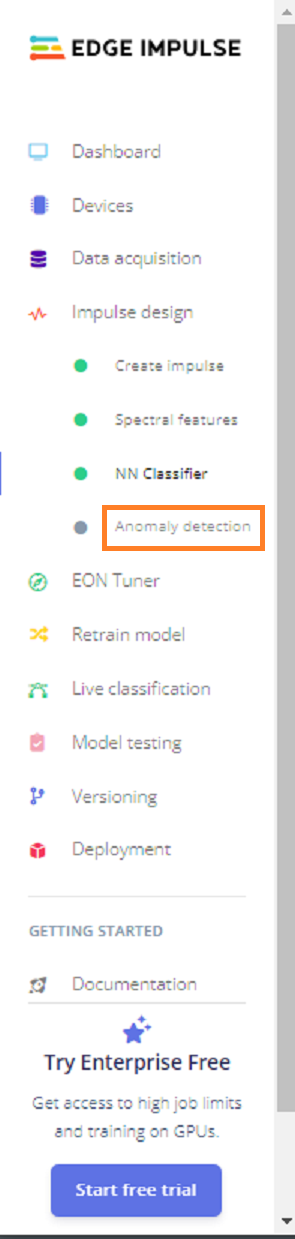

Save impulseを実行するとメニュが以下の様に追加されています。以降、順番に実行します。

全部やり終えないとStudioに文句を言われてDeployment にたどり着きません。終了するとグレーの丸がグリーンの丸に変わります。

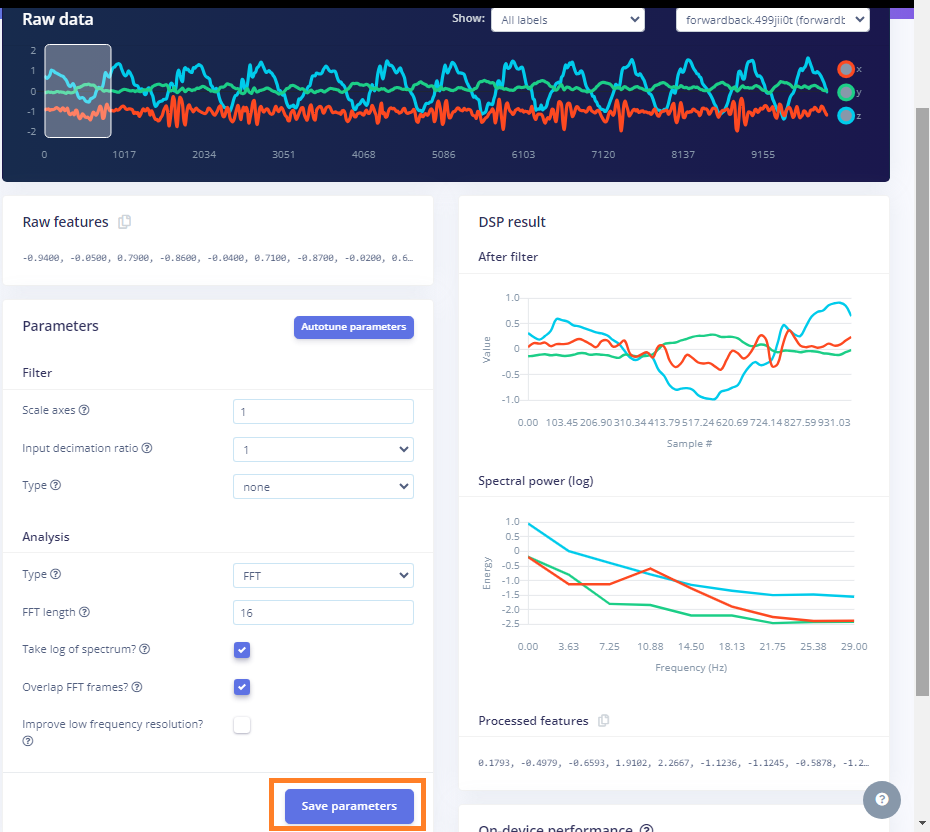

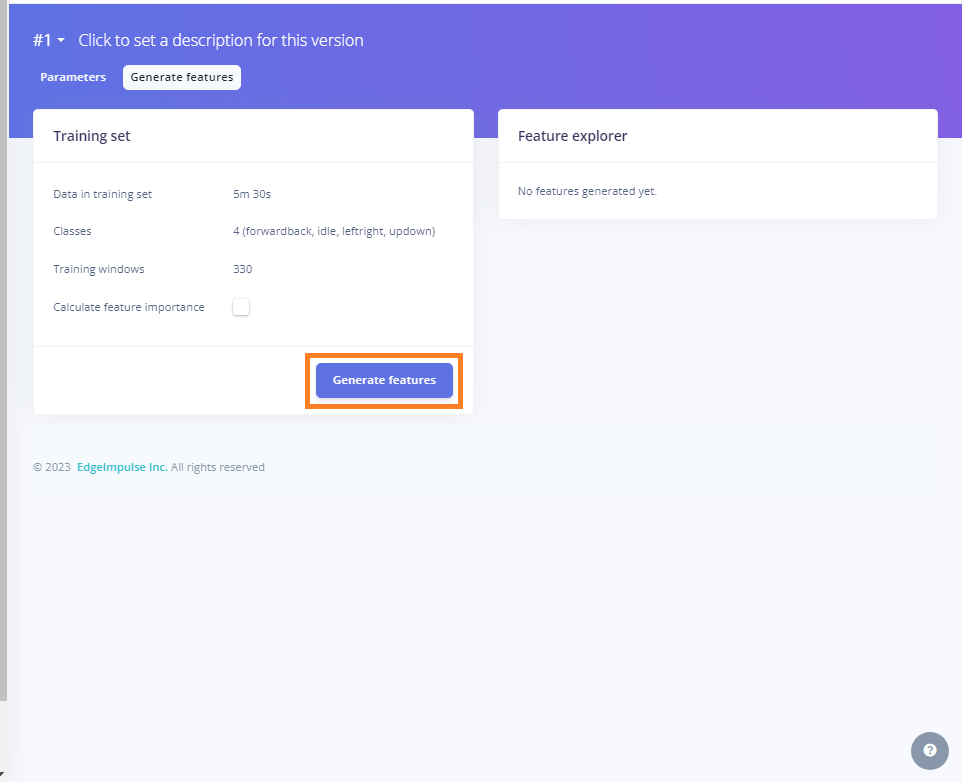

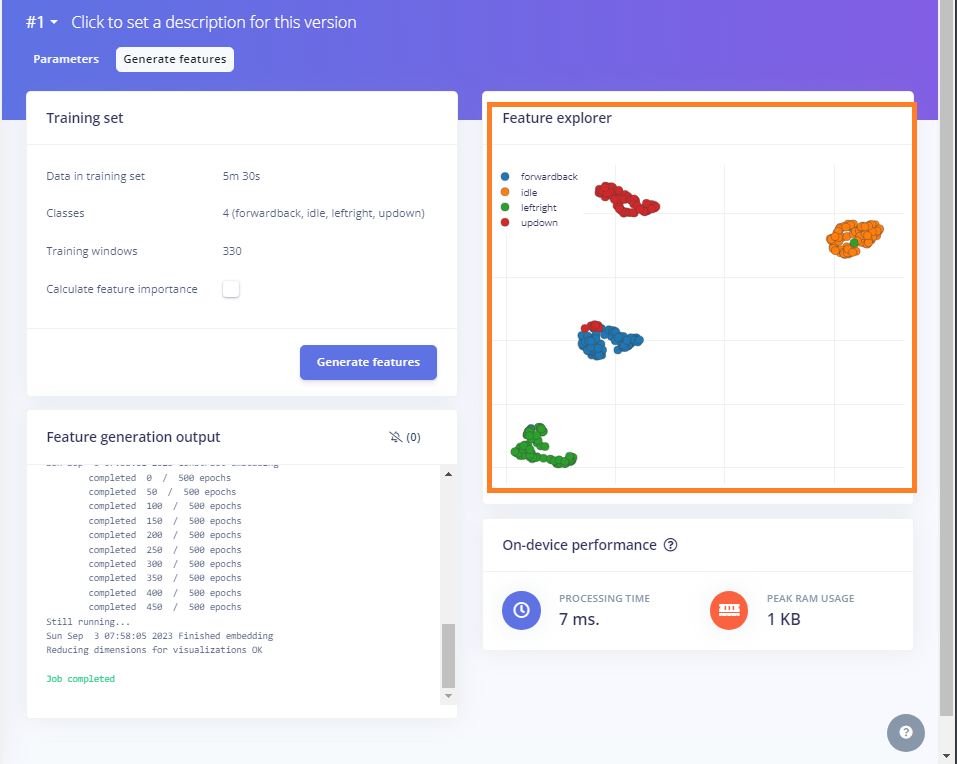

まずはSpectral features です。

パラメータは変更したほうがいいのかもしれませんが、とりあえずデフォルトで実行。

explorerにデータがバラついて表示されているので、いい感じです。

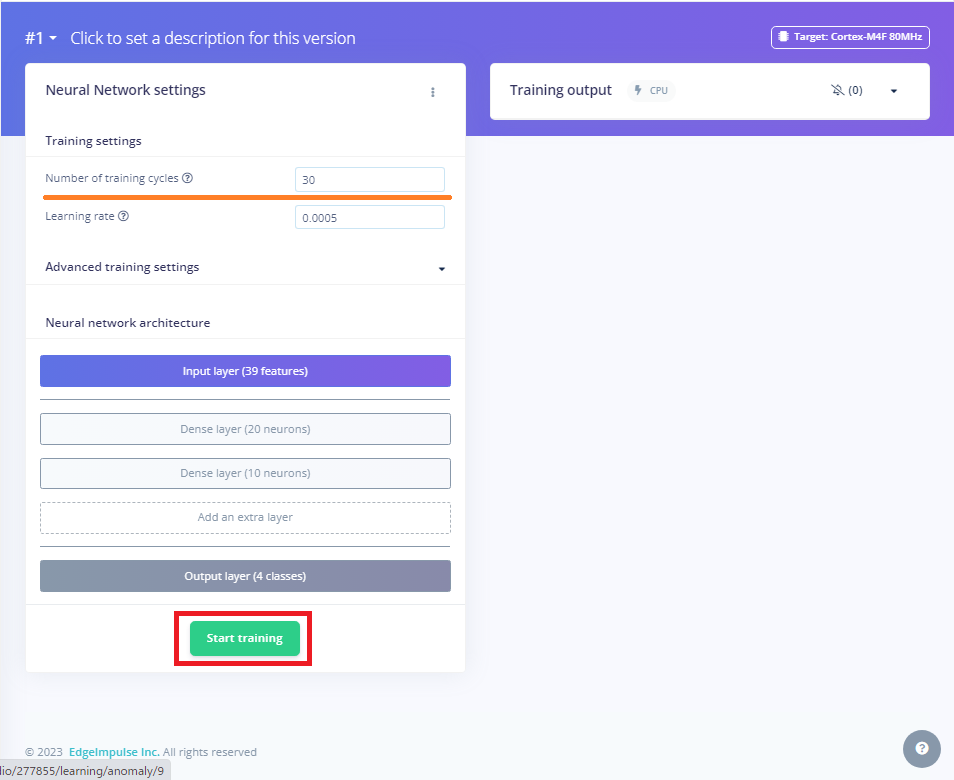

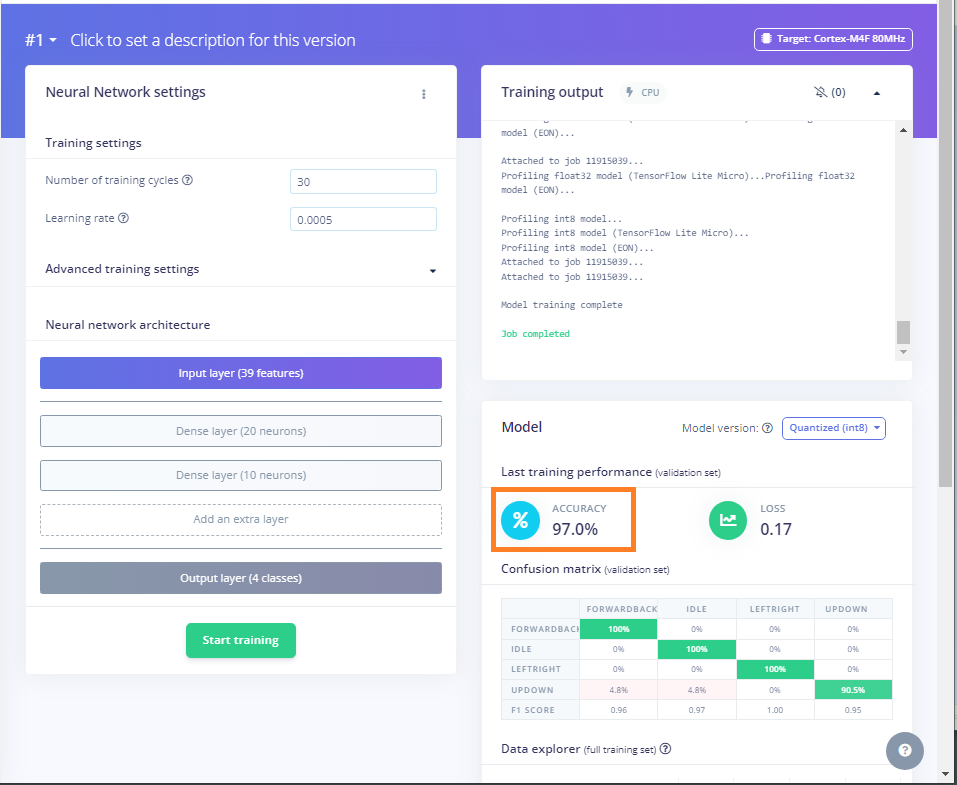

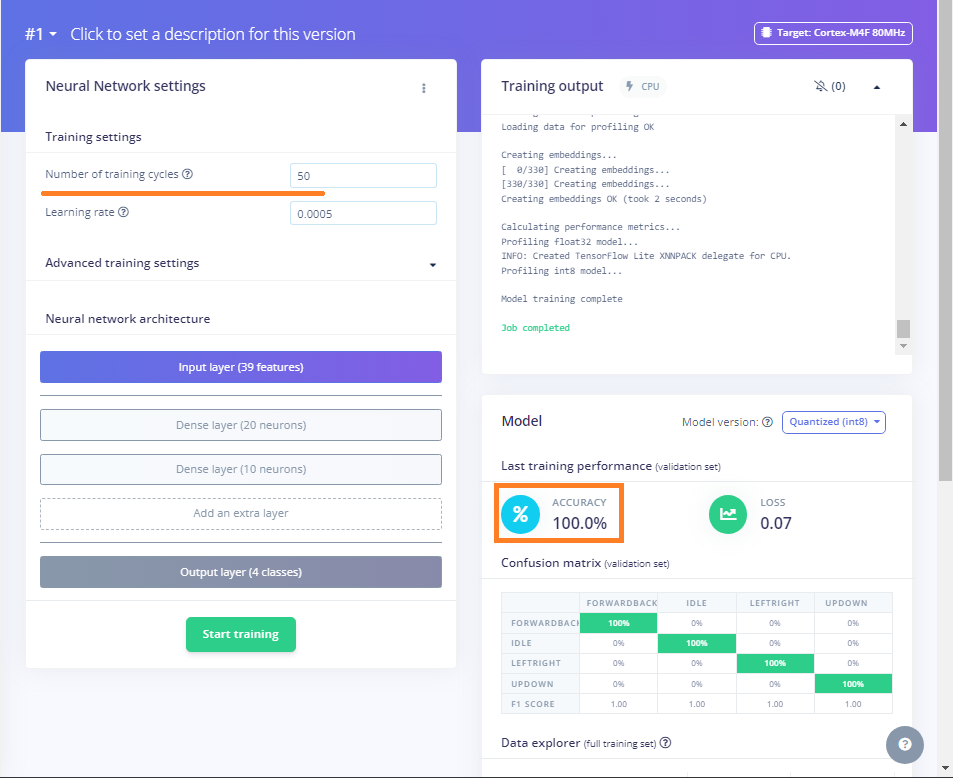

分類(Neural Network Classifier)実行

Number of training cycles というのはエポックという名称で知られている数です。デフォルト30で実行してみます。

Accuracy が97%でした。悪くない数字ですが、エポックを上げながらもう少しやってみます。

なんとエポック50で100%になってしまいました。大丈夫か?と思ってしまいますが折角なのでこれを採用してみます。

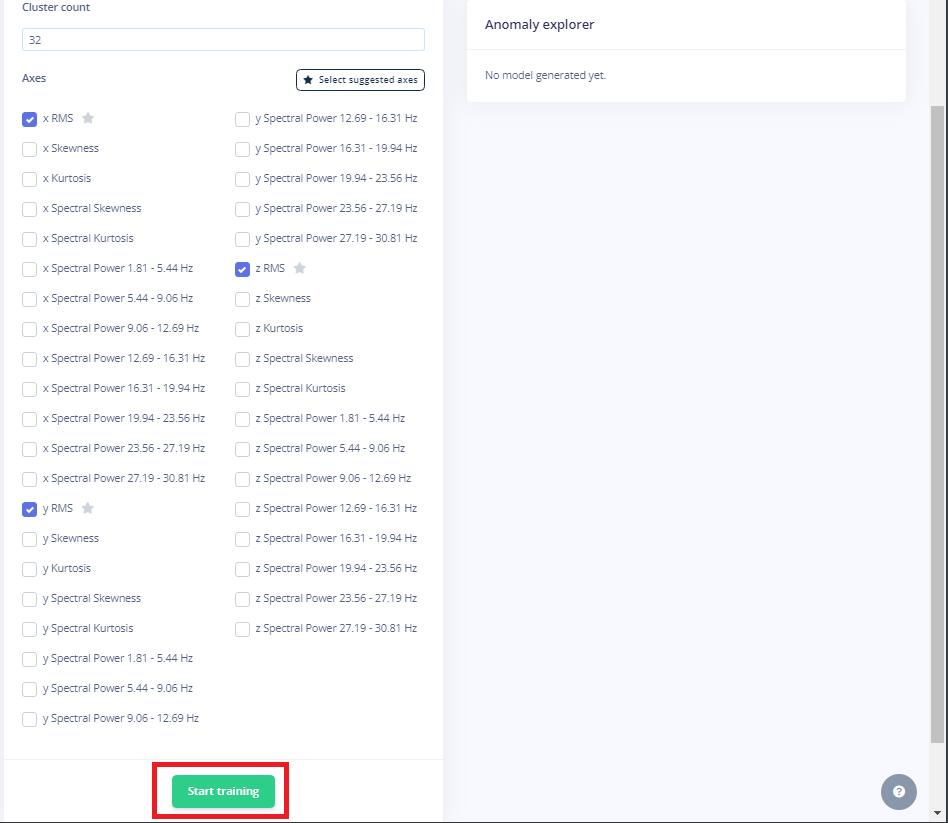

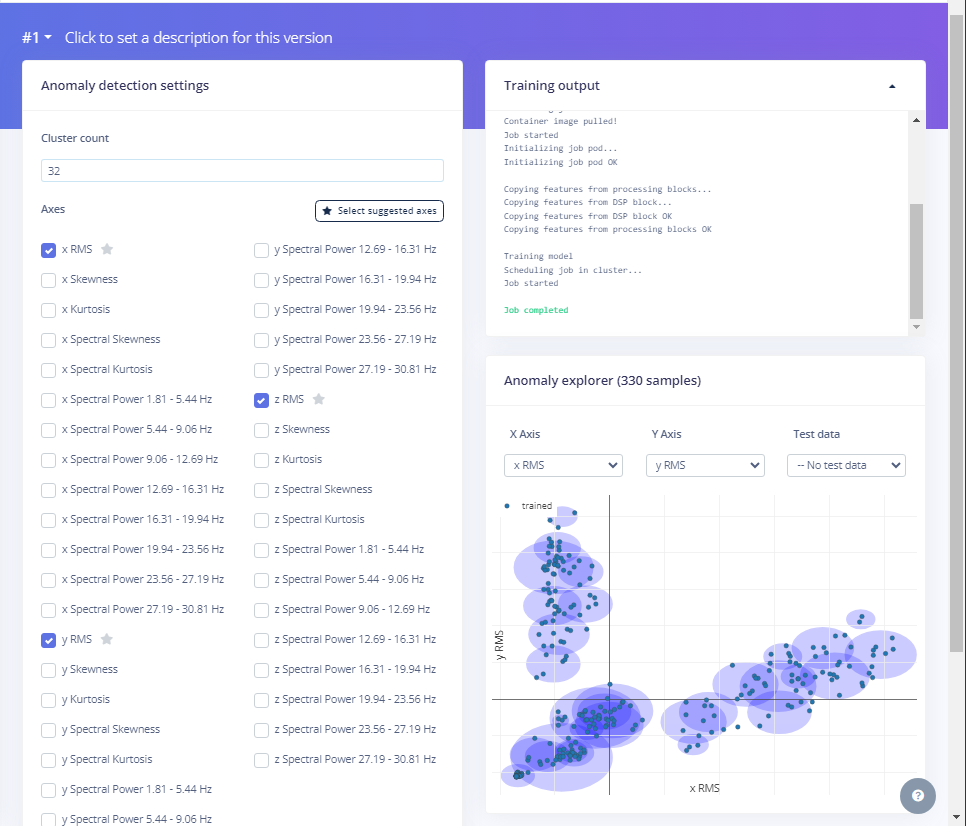

最後に異常値検出です。これはどうもデータに存在するあり得なさそうな数値を排除するのにつかわれるのでしょうか?良くわかりませんが必要です。

以下のX,Y,Zの3つのRMSの項にチェックを入れて最終トレーニングを実行してモデルを作成します。

テスト

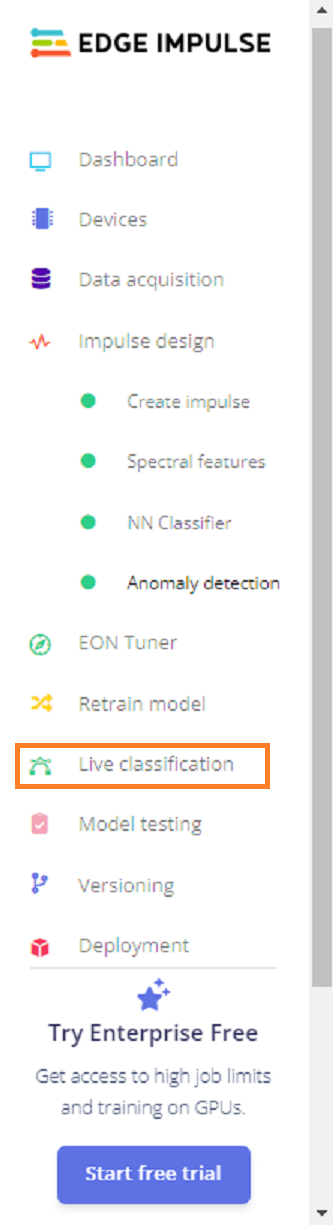

生成されたモデルで実際のデータを使って推論を実行してみます。

10秒間、モーション(updown , leftright , forwardback)をやって分類できているかテストします。

leftright を実行してみました。

結構な正確さで分類されています。

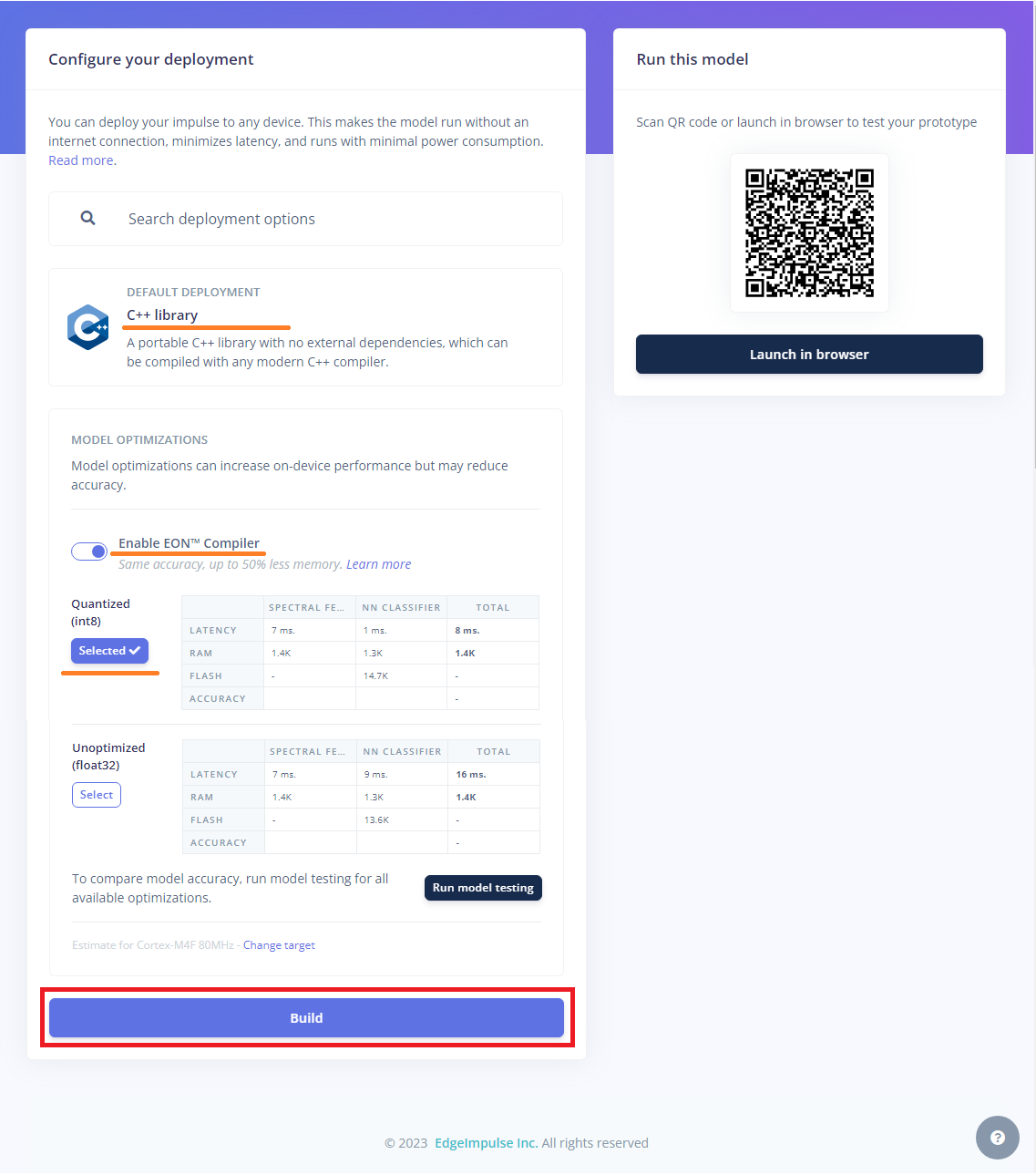

デプロイ用パッケージ作成

成果物をC++Liburary としてアーカイブしてローカルにダウンロードします。

オプションはデフォルトのままでビルドします。

終了。

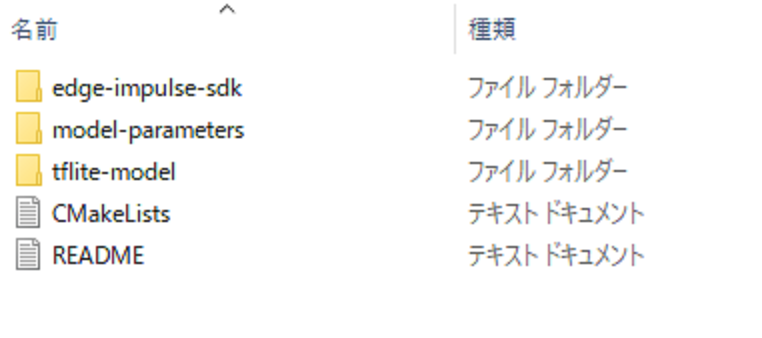

ローカルPCのダウンロードフォルダーにZIPファイルが落とされています。

中身はこんな感じ。

必要なのは3つのフォルダーで、これをラズパイに移行します。

デプロイ実行

ラズパイに最初にPico SDK をインストールしたpico ディレクトリにプロジェクト用のフォルダーを作成します。

|

1 |

mkdir ~/pico/motion-multicore-inferencing-pico |

このフォルダーに必要なフォルダーやファイルをコピーしていきます。

最終的にはこんな構造になります(LICENSEやREADME.mdなどは端折っています)。

~/pico/

├── motion-multicore-inferencing-pico/

│ ├─ edge-impulse-sdk/

│ ├─ model-parameters/

│ ├─ tflite-model/

│ ├─ source/

│ ├─ build/

│ ├─ CMakeLists.txt

│ └─ pico_sdk_import.cmake

│

├── pico-sdk/

│ ├── cmake

まず、上記でダウンロードしたZIPファイルの中の3つのフォルダー(edge-impulse-sdk、model-parameters、 tflite-model)を~/pico/motion-multicore-inferencing-picoにコピーします。

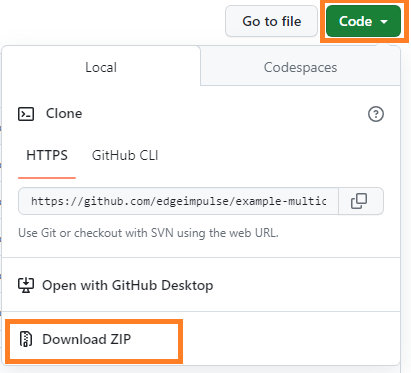

次に、Multicore Pico Example repository をダウンロードするかクローンしておきます。

これはファームウェアのひな型のようなものです。

or

|

1 |

git clone https://github.com/edgeimpulse/example-multicore-inferencing-pico.git |

この中から以下のフォルダーとファイルを上で作成したmotion-multicore-inferencing-picoフォルダーにコピーしておきます。

sourceフォルダー

CMakeLists.txt

pico_sdk_import.cmake

次に3つのファイルを編集します。

● CMakeLists.txtを開いて、example_multicoreをmotion_multicore に一括置換(名前を合わせてるだけ)。

● source/accelerometer.cppを開いて以下の様に変更(最初の結線の形に合わせているだけ)。

#define I2C_INTERFACE i2c0

#define I2C_SDA_PIN 4

#define I2C_SCL_PIN 5

● source/ei_classifier_porting.cppを開いて以下のように2つの関数をコメントアウト(リンクエラーを防ぐため)。

/*

uint64_t ei_read_timer_ms()

{

return to_ms_since_boot(get_absolute_time());

}

uint64_t ei_read_timer_us()

{

return to_us_since_boot(get_absolute_time());

}

*/

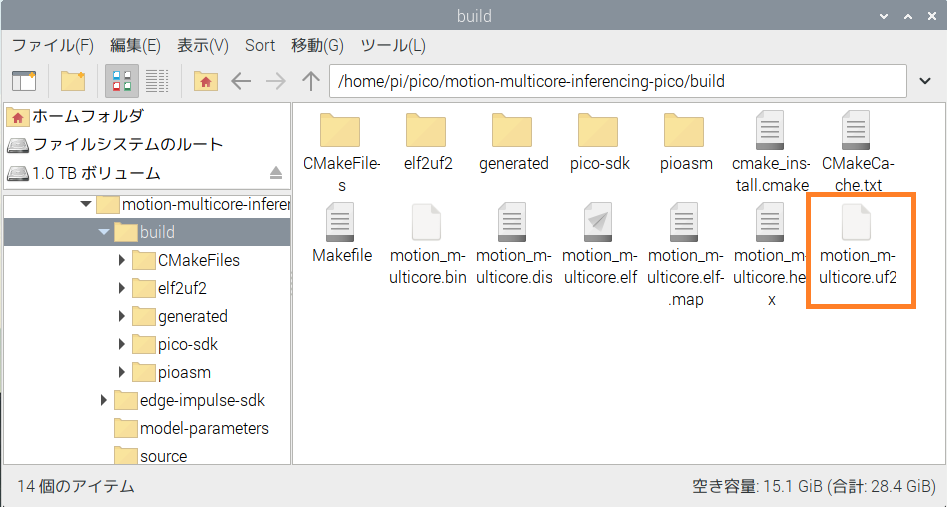

実行用ファームウェアをビルドして作成します。

|

1 2 3 4 5 |

cd ~/pico/motion-multicore-inferencing-pico mkdir build && cd build cmake .. && cmake --build . --parallel |

buildフォルダーにmotion_multicore.uf2が生成されているのを確認。

PicoのBOOTSELボタンを押しながらMicroUSBケーブルでラズパイに接続。

Pico がストレージとして認識されてフォルダーが開くので、作成したuf2ファイルをドラッグ・ドロップします。Pico は再起動してコードが実行されます。

推論実行

minicomを開いてシリアルポートをモニターします。

|

1 |

minicom -b 115200 -o -D /dev/ttyACM0 |

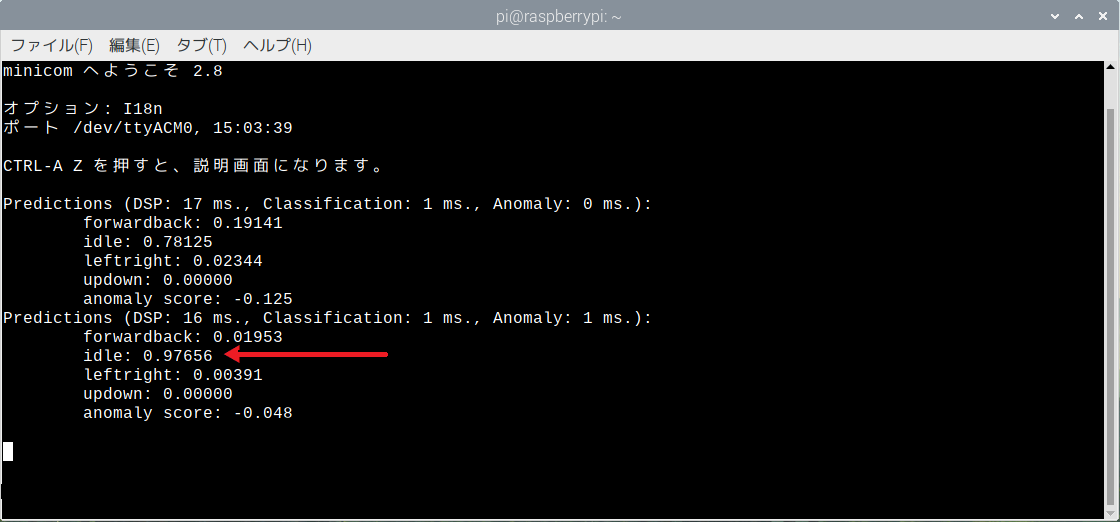

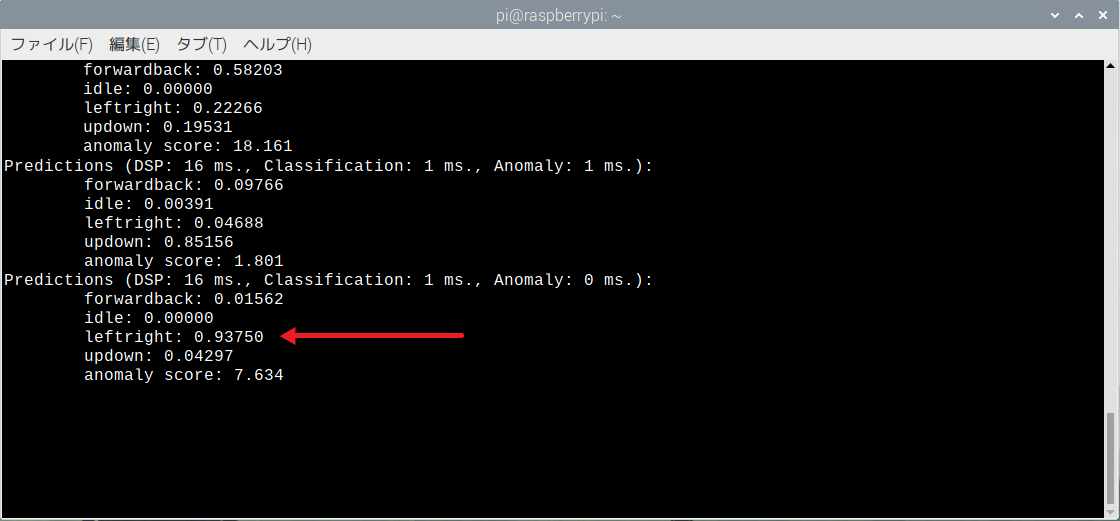

最初は何もしていない状態なので、idleに高い数値が出ています。

leftright の動作を実行すると、その動きは以下の様に推論されます。

この結果表示のコードは、source/main.cpp です。

注:source/core1_thread.cppにあるようにLEDは25pin にアサインされています。したがってPico ではLEDが点滅しますがPico W ではしません。W ではWL_GPIO0 を指定します。

Appendix

他のモーションについて

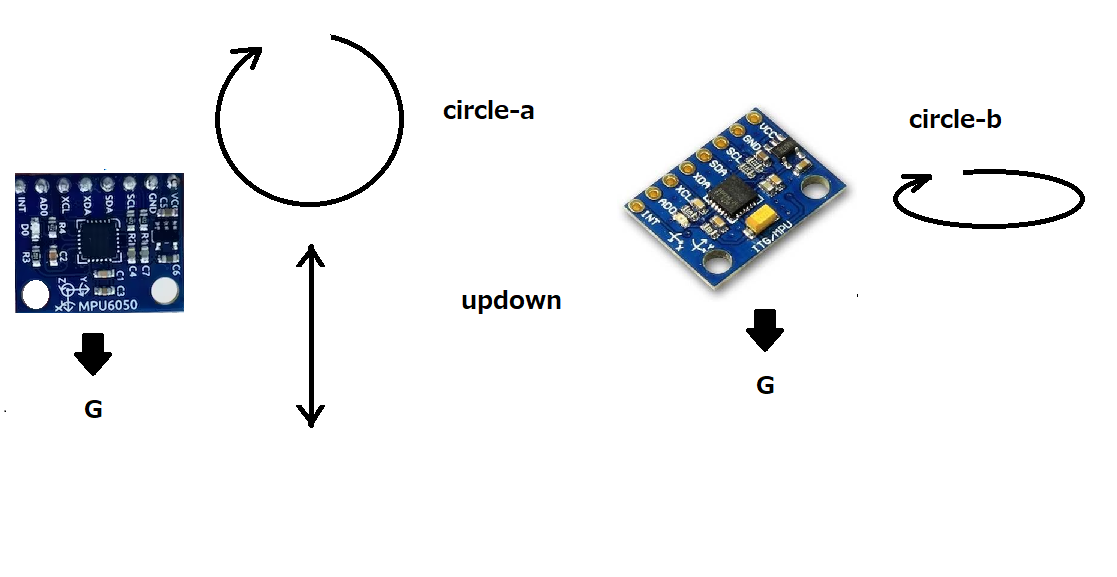

以下のようなモーションを試してみました。

1・

サンプリング数:各10秒を10回

Accuracy : 99.3 % (epoch 60)

この3つのモーションはかなり正確に認識されました。

2.

サンプリング数:各10秒を10回

Accuracy : 93.5 % (epoch 60)

これらのモーションについてはUpdown とCircle は区別されましたが、

Circle がどちらなのかはあいまいでした。つまり、サンプリングする場合、どちらもCircle としてデータを取っておいて問題ないかな……と思います。あるいは、サンプリング数を増やせば、circle-aとcircle-bはもう少しはっきりと区別されるかもしれません。

* サンプル数を増やすとAccuracy はやはり上がります。ただcircle-aとcircle-bだけ増やすとAccuracyはかえって下がります。やはりバランスが大事。全部を10s x 6増やすだけで、Accuracy は94.6% (epoch 50)でcircle-aとcircle-bも差別化がはっきりするようになりました。

Leave a Reply